|

机器之心报道

3 ^$ S0 Q" E( G P5 R+ r! S - O* V5 C) [& k" t& P8 T

机器之心编辑部 ; f9 B" W5 y: w7 N7 ]# M

李飞飞的又一位得意门生走向了教学岗位:昨天,刚刚毕业的斯坦福博士朱玉可(Yuke Zhu)宣布即将在 2020 年秋季加入德克萨斯大学奥斯汀分校(The University of Texas at Austin)任助理教授。

, E) a9 u0 X9 B/ k% {! [' G2 Y/ \* }( v: w: y

作为斯坦福视觉与学习实验室的成员,朱玉可师从李飞飞与 Silvio Savarese 教授。他因在 SURREAL 机器人框架研究中的贡献而被人所熟知。此外,朱玉可还作为共同第一作者获得了国际机器人顶会 ICRA 2019 的最佳论文奖。

, @4 h, P* f! Q+ Q4 B! X, A% @

朱玉可在 Twitter 上发布的信息:本人已于 2019 年 8 月取得斯坦福大学博士学位,并将于 2020 年秋季加入德克萨斯大学奥斯汀分校(UT-Austin)担任计算机科学助理教授。我非常期待与那些对 AI+机器人学充满热情和积极性的优秀学生共同进步。如果有兴趣加入我的实验室,请发邮件给我。 朱玉可在 Twitter 上发布的信息:本人已于 2019 年 8 月取得斯坦福大学博士学位,并将于 2020 年秋季加入德克萨斯大学奥斯汀分校(UT-Austin)担任计算机科学助理教授。我非常期待与那些对 AI+机器人学充满热情和积极性的优秀学生共同进步。如果有兴趣加入我的实验室,请发邮件给我。

/ {: l& u# y0 \# G1 R5 Y9 P1 ^

0 S/ ~3 _' _: f+ M7 D$ C% X; C( U. Y& @. q

根据朱玉可的个人主页,他的科研兴趣是为能够理解并与现实世界交互的通用机器人构建智能。研究将融合机器人、计算机视觉和机器学习等诸多领域,并致力于开发用于通用机器人自治的感知和控制方法和机制。

8 f1 s. y& p3 b

% @: a4 C4 G5 V- p" z在斯坦福大学,他与李飞飞和 Silvio Savarese 教授(李飞飞的丈夫)一起在斯坦福视觉与学习实验室工作。同时,他也是斯坦福人工智能和机器人研究小组(Stanford People, AI & Robots Group,PAIR)成员。

) z2 a3 ?0 k' L: W' x

9 a1 H3 S: |, D) v4 a6 V6 @ 今年 6 月,朱玉可在斯坦福大学的博士论文答辩后,与李飞飞等人合影。 今年 6 月,朱玉可在斯坦福大学的博士论文答辩后,与李飞飞等人合影。

# |: \/ U& r' P( Z: ?1 H

" i* k; U" R) A+ m& w# Q虽然朱玉可还没有开始任教,但你很可能已经听过他讲课了。在斯坦福大学期间,朱玉可还参与了一些课程的教学工作——其中包括著名的 CS 231N:视觉识别中的卷积神经网络。此外还有 CS 131、CS 193C、CS 431 等。# @) q& F! V* x

# _: {- ] z- h( b! \, b g" ?) T$ f

从浙大到斯坦福) }' f2 X# B! x$ m+ E- P2 E! A

% U* _9 L' _5 @

朱玉可的求学履历可谓豪华。本科阶段,他参与了联合培养项目,取得了浙江大学和加拿大西蒙弗雷泽大学(Simon Fraser University,简称 SFU)的双学位,并在所有学生中成绩排名第一。8 `: @8 q. z# ^. z( l- S

8 q5 J8 S- |0 d7 S

朱玉可曾荣获浙江省第八届 ACM 大学生程序设计竞赛金牌、浙江大学第十一届大学生程序设计竞赛一等奖以及加拿大西蒙弗雷泽大学第八届年度冬季程序设计竞赛第一名。! _' [' \2 S# s8 Q' F! r

: Z* b# W% j9 z& k! Y* u他硕士和博士研究生均就读于斯坦福大学,师从计算机视觉大牛李飞飞,于今年 8 月取得博士学位。

+ w# x7 T/ E0 u0 X3 ~7 r! j! M, j 朱玉可漫漫求学路。 朱玉可漫漫求学路。

1 o6 x2 b Q$ b: n( I: H, V6 c0 ?7 c

一路走来,朱玉可的实习工作履历也颇为丰富。( O* V. a i8 r, ?$ b4 q

0 [! `- ]+ l9 E! \自 2011 年起,朱玉可曾先后在加拿大西蒙弗雷泽大学视觉与媒体实验室(Vision and Media Lab)、推特、Snap、艾伦人工智能研究所、DeepMind 等公司和科研机构担任研究实习生。此外,自进入斯坦福大学攻读硕博研究生起,朱玉可就担任了教学助理和助理研究员。

8 B5 u' }* w( I. C* B' s. a7 W! F3 q9 Y# @: Y7 c& L+ }$ ^

研究经历2 M! _8 X$ g6 r6 R6 E" v9 n

/ h- N" @4 a/ G N. O5 i

在斯坦福大学攻读博士期间,朱玉可曾有多篇论文被各类人工智能大会接收,并获得过一些奖项。目前,朱玉可有 1 篇论文被 ECCV 接收,另外还有 3 篇 ICCV,5 篇 CVPR 和 3 篇 ICRA。

" O% H, s% W i* L

* f" a) {$ b: L! G1 w. {; O其实早在本科学习期间,他的论文《Graphical Model-based Learning in High Dimensional Feature Spaces》就被 AAAI 2013 接收了。* y1 Y9 n% ?5 E2 ?

/ [, t4 K* `+ A8 _2 Y8 [- A

当然,还有最佳论文奖:

5 S/ G3 r0 q" q

" E/ C$ p% j0 ~+ l' u" p今年 5 月,在加拿大蒙特利尔举行的机器人顶级会议 ICRA 大会公布了最佳论文奖项,来自斯坦福大学李飞飞组的研究《Making Sense of Vision and Touch: Self-Supervised Learning of Multimodal Representations for Contact-Rich Tasks》获得了最佳论文。% M9 V: A4 H. ~: _' O

" a9 C( h7 N+ j, \& {- \! W, \该研究有关在非结构化环境中执行需要大量接触的操纵任务。通过自监督学习感知输入的紧凑、多模态表征,然后使用表征提升策略学习的样本效率。研究者在植入任务上评估了新方法,其结果表明该方法对于外部扰动具备稳健性,同时可以泛化至不同的几何、配置和间隙(clearances)。研究者们还展示了新方法在模拟环境中和真实机器人上的结果。, `# G9 ?$ K! v# M; ?* {( z2 i

$ n% X( C% m! ]: W7 Z在斯坦福计算机视觉与学习实验室扮演重要角色

0 Z( {' T% t, s; R! z! @+ ] o

! C% B( o# P( h! G朱玉可在李飞飞夫妇带领的斯坦福大学计算机视觉与学习实验室的一个团队中也扮演着重要角色。

7 `" ~! ]3 g, S. y

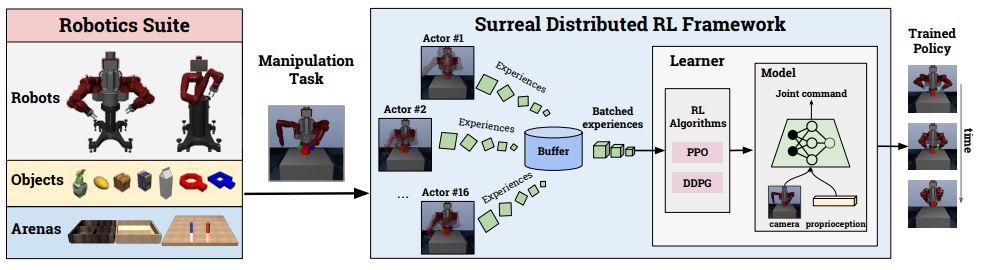

; e+ m9 N$ e$ T. p8 {7 Q该团队开发了两个机器人学习框架——RoboTurk 和 SURREAL,能够让机器人快速学习抓握、分拣等基础技能。其中,RoboTurk 是一个快速众包制造大规模机器人控制数据集的平台,可以让机器人研究者快速收集数据,打造机器人界的「ImageNet」,以填补这一领域缺乏数据集的空白。有了数据集,还需要鲁棒的算法。为此,李飞飞团队开发了分布式强化学习训练框架 SURREAL,用来加速学习过程,而朱玉可正是这一项目背后的一作之一。+ W5 x/ i- U# c# Y

( O1 d* f* ~4 R* H5 K3 ^! ]

# X! ]: }+ F2 ~) R6 {

& I2 ?- n2 H9 w" V

$ L8 Y6 z1 L D+ j5 w1 o, ^) m可复现性一直都是深度强化学习和机器人研究中的一大挑战,朱玉可等人设计的 SURREAL 作为一个开源框架,可以在严格的评估和可复现研究中发挥重要作用。SURREAL 是一个可扩展的框架,支持当前最先进的分布式强化学习算法。他们设计了一个原则性的分布式学习平台,既能适应策略上的学习,也能适应政策外的学习。他们还证明了 SURREAL 算法在智能体性能和学习效率方面都优于原有的开源实现。* y- D5 `3 o7 E% R

% K4 b r a6 U6 x

8 j; Z! G6 S2 B. ]SURREAL 是一个开源的框架,旨在促进机器人操纵可复现深度强化学习研究。

5 K* b& x, z! }) V ; B* m9 f! X3 T5 q6 N8 a

; h, R! M# U" n; ]1 T3 x; l% E9 ?

6 |+ o/ Q# M6 }& T5 H% }, Z+ ~% x7 _' o* p8 h3 N

+ }5 L c: \2 Q9 s

) R4 R) O1 Z, b% }, E# Z+ v( ?" z1 E& O7 z# y+ a5 q/ w1 n+ {4 A/ Z

本文为机器之心报道,转载请联系本公众号获得授权。7 X0 u3 Z2 e- l' s6 Y! M

✄------------------------------------------------加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com投稿或寻求报道:content@jiqizhixin.com广告 & 商务合作:bd@jiqizhixin.com3 _9 m: p/ ^8 D) k' P

来源:http://mp.weixin.qq.com/s?src=11×tamp=1567584003&ver=1831&signature=nFGGTdVbZ2-DOffiH-rBYy5IgpO9NExnjJjD1QdqLjrijoDJRnWNicYYoCboUOSi-GbiDmbbdOFf*1GWhxXdMgdFU0M*TNM4nPPAF43br2tv9cIMnI-VO-461lAbq0vV&new=14 J6 E2 b+ {8 f c1 W5 d

免责声明:如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作! |  |手机版|小黑屋|梦想之都-俊月星空

( 粤ICP备18056059号 )|网站地图

|手机版|小黑屋|梦想之都-俊月星空

( 粤ICP备18056059号 )|网站地图